You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Nvidia Geforce Thread

- Thread starter Spasstiger

- Start date

DoomDoctor20

Arch-Vile

So Leid es mir tut, ich seh beim besten Willen keinen Unterschied bei dem Halflife Shot. Solange Nvidia mal mit ATIs Bildqualität mithalten kann bin ich glücklich.

Skulltaker

Knight

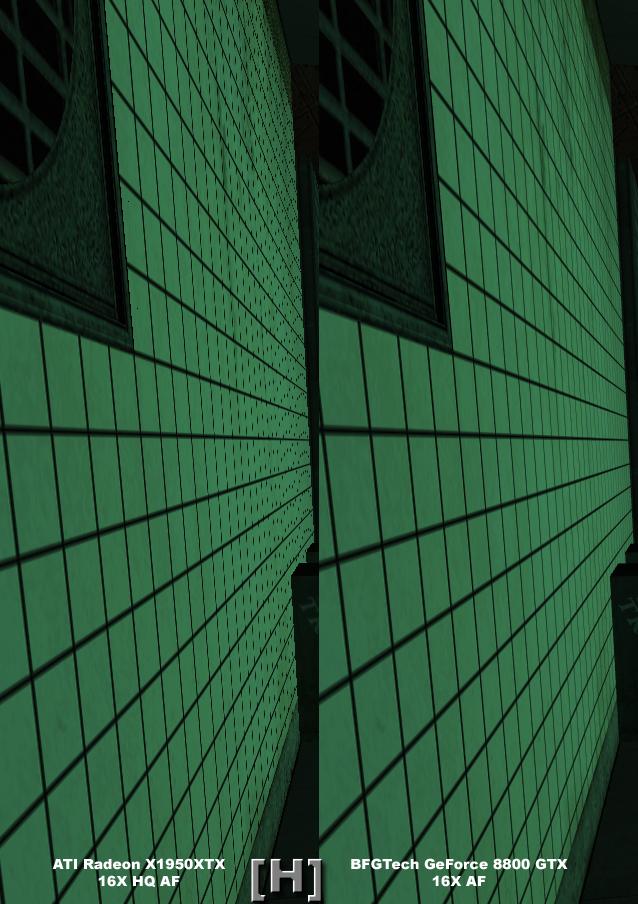

Ein Unterschied zwischen Ati X1950 XTX Default x 16 AF und Nvidia 8800 GTX Default x 16 AF siehst du. Oder? Bei Ati X1950 XTX HQ x 16 AF und Nvidia 8800 GTX Default x 16 AF ist es gleich,aber ich schätze mal wenn man HQ x16 AF bei der 8800 GTX einschaltet sieht es besser aus als Ati HQ x 16 AF.Originally posted by DoomDoctor20@08.11.06, 18:14

So Leid es mir tut, ich seh beim besten Willen keinen Unterschied bei dem Halflife Shot. Solange Nvidia mal mit ATIs Bildqualität mithalten kann bin ich glücklich.

Spasstiger

Crash

Es ist wohl eher so, dass Nvidia bei der GTX by default HQ fährt, während man es bei ATI erst aktivieren muss (was man mit einer High-End-Karte aber in jedem Fall machen sollte, die Geschwindigkeitseinbußen liegen im Fall von ATI bei vielleicht 5%).Originally posted by RedTitanBoik@08.11.06, 19:36

Bei Ati X1950 XTX HQ x 16 AF und Nvidia 8800 GTX Default x 16 AF ist es gleich,aber ich schätze mal wenn man HQ x16 AF bei der 8800 GTX einschaltet sieht es besser aus als Ati HQ x 16 AF.

Pyromaniac

Baron

Ich habe auch erstmal lange bei den HL2-Screenshots suchen müssen, aber an der linken Mauer, die so schräg ist, sieht man einen deutlichen Unterschied zwischen Bild 1 und 2 bzw. 3 aber zwischen dem 2. und 3. Bild sieht man keinen Unterschied mehr. Das kann man vielleicht noch berechnen und messen lassen, aber sichtbar ist es bestimmt nicht mehr.

DoomDoctor20

Arch-Vile

Es ist wohl eher so, dass Nvidia bei der GTX by default HQ fährt, während man es bei ATI erst aktivieren muss (was man mit einer High-End-Karte aber in jedem Fall machen sollte, die Geschwindigkeitseinbußen liegen im Fall von ATI bei vielleicht 5%). [/b][/quote]Originally posted by Spasstiger+08.11.06, 19:06--></div><table border='0' align='center' width='95%' cellpadding='3' cellspacing='1'><tr><td>QUOTE (Spasstiger @ 08.11.06, 19:06)</td></tr><tr><td id='QUOTE'> <!--QuoteBegin-RedTitanBoik@08.11.06, 19:36

Bei Ati X1950 XTX HQ x 16 AF und Nvidia 8800 GTX Default x 16 AF ist es gleich,aber ich schätze mal wenn man HQ x16 AF bei der 8800 GTX einschaltet sieht es besser aus als Ati HQ x 16 AF.

Ich dachte wenn von HQ die Rede ist geht es um die Grafikeinstellungen im Spiel, aber wenn es um die Einstellungen der Graka geht ist natürlich der Vorteil klar zu erkennen. War mir nicht ganz klar. Doch beachtlich

@Pyromaniac. Ja aber der Unterschied liegt halt bei der Einstellung. ATI muss auf HQ einstellen und Nvidia auf default um die selbe Leistung zu erreichen.

Der Kampf um die besser Bildqualität kommt dem Nutzer echt zu gute. Bin mal echt auf die Zukunft gespannt.

Pyromaniac

Baron

Ich dachte wenn von HQ die Rede ist geht es um die Grafikeinstellungen im Spiel, aber wenn es um die Einstellungen der Graka geht ist natürlich der Vorteil klar zu erkennen. War mir nicht ganz klar. Doch beachtlichOriginally posted by DoomDoctor20+08.11.06, 19:11--></div><table border='0' align='center' width='95%' cellpadding='3' cellspacing='1'><tr><td>QUOTE (DoomDoctor20 @ 08.11.06, 19:11)</td></tr><tr><td id='QUOTE'>Originally posted by Spasstiger@08.11.06, 19:06

<!--QuoteBegin-RedTitanBoik@08.11.06, 19:36

Bei Ati X1950 XTX HQ x 16 AF und Nvidia 8800 GTX Default x 16 AF ist es gleich,aber ich schätze mal wenn man HQ x16 AF bei der 8800 GTX einschaltet sieht es besser aus als Ati HQ x 16 AF.

Es ist wohl eher so, dass Nvidia bei der GTX by default HQ fährt, während man es bei ATI erst aktivieren muss (was man mit einer High-End-Karte aber in jedem Fall machen sollte, die Geschwindigkeitseinbußen liegen im Fall von ATI bei vielleicht 5%).

@Pyromaniac. Ja aber der Unterschied liegt halt bei der Einstellung. ATI muss auf HQ einstellen und Nvidia auf default um die selbe Leistung zu erreichen.[/b][/quote]

ja das kann schon sein, mein Beitrag war nur darauf bezogen dass hier einer meinte dass er GARKEINEN unterschied zwischen den HL2-Screenshots sehen würde.

edit: ach das warst ja sogar DU

sinot

Revenant

hey ihr könnt lange rumvergleichen zwischen standbildern und bewegten bildern ist ein riesenunterschied. ich bin überzeugt das die übergänge mehr als nahtlos sind sondern absolut weich auslaufen ohne flackern und überschneidungen zu hinterlassen.

am besten wird man es bei shootern und Rollenspielen wo sich die karte mitbewegt (verschwimmeffekt) sehen wie die qualität der neuen karten sind.

*speichel am rechten Mundwinkel heruntertropf*

mfg sinot

am besten wird man es bei shootern und Rollenspielen wo sich die karte mitbewegt (verschwimmeffekt) sehen wie die qualität der neuen karten sind.

*speichel am rechten Mundwinkel heruntertropf*

mfg sinot

DoomDoctor20

Arch-Vile

Ich kauf mir die Karte wohl erst im Sommer oder Herbst. Achso ich brauch mal Tipps weil meine x1900xt nicht mehr lieferbar ist. Gute bzw. gleichwertige Alternative im Bereich von 270-310¤?

Saliva

Orbb

Ich glaube das trifft es ganz gut."Ob es sinnvoll ist, jetzt schon 450,- bis 600,- Euro in eine Grafikkarte zu investieren, deren Funktionen vielleicht erst in fünf Monaten mit den ersten DirectX-10-Spielen genutzt werden können, erscheint angesichts des Wertverlustes immerhin zweifelhaft." golem.de

DoomDoctor20

Arch-Vile

Denkst du wirklich, dass sie vergleichbar mit der 1900xt ist? Die xt schlägt die 7900gt ja schon recht eindeutig, vor allem bei hohen Auflösungen.

Spasstiger

Crash

Für Sparer gibts auch noch die Radeon X1950 Pro mit 512 MB. Ist bei Geizhals schon ab 210 Euro in einer Variante (von PowerColor) mit leisem Arctic-Cooling-Lüfter gelistet. Die Karte ist ungefähr so schnell wie eine GeForce 7900 GT mit 512 MB, teilweise etwas langsamer.

Gegenüber einer X1900 XT ist sie natürlich nochmal merklich langsamer, kostet aber auch etwas weniger.

Aber mal zurück zur GeForce 8800 GTX, in Oblivion klare Dominanz des neuen Nvidia-Prunkstücks:

http://www.computerbase.de/artikel/hardwar...ce_8800_gtx/20/

Auch bei gleichzeitiger Verwendung von fp16-HDR-Rendering und AntiAliasing (was ja bei Nvidia erst aber GeForce 8 geht), das gleiche Bild:

Also für Zocker mit hohem Anspruch an die Bildqualität ein Traumkärtchen. Sonst ist die GeForce 8800 GTX auf Mainstream-CPUs in der Regel bei Standard-Bildschirmauflösungen (meist 1280x1024) stark CPU-limitiert, oft brauchts einen Core 2 Duo auf 4 GHz übertaktet, um überhaupt einen spürbaren Unterschie zur vorigen Generation feststellen zu können.

Hier kann man sich übrigens kurze Animationen aus den neuen Techdemos anschauen:

http://www.nvidia.com/page/geforce8.html (auf die Play-Buttons in den Bildern klicken)

Und hier noch aus der Techdemo mit dem Playmate Adrianne Curry:

Mehr Screenshots aus den Techdemos und Benchmarks unter http://www.firingsquad.com/hardware/nvidia...e_8800_preview/.

P.S.: Nvidia beweist Humor -> http://download.nvidia.com/downloads/nZone...celess_360P.wmv

Gegenüber einer X1900 XT ist sie natürlich nochmal merklich langsamer, kostet aber auch etwas weniger.

Aber mal zurück zur GeForce 8800 GTX, in Oblivion klare Dominanz des neuen Nvidia-Prunkstücks:

http://www.computerbase.de/artikel/hardwar...ce_8800_gtx/20/

Auch bei gleichzeitiger Verwendung von fp16-HDR-Rendering und AntiAliasing (was ja bei Nvidia erst aber GeForce 8 geht), das gleiche Bild:

Also für Zocker mit hohem Anspruch an die Bildqualität ein Traumkärtchen. Sonst ist die GeForce 8800 GTX auf Mainstream-CPUs in der Regel bei Standard-Bildschirmauflösungen (meist 1280x1024) stark CPU-limitiert, oft brauchts einen Core 2 Duo auf 4 GHz übertaktet, um überhaupt einen spürbaren Unterschie zur vorigen Generation feststellen zu können.

Hier kann man sich übrigens kurze Animationen aus den neuen Techdemos anschauen:

http://www.nvidia.com/page/geforce8.html (auf die Play-Buttons in den Bildern klicken)

Und hier noch aus der Techdemo mit dem Playmate Adrianne Curry:

Mehr Screenshots aus den Techdemos und Benchmarks unter http://www.firingsquad.com/hardware/nvidia...e_8800_preview/.

P.S.: Nvidia beweist Humor -> http://download.nvidia.com/downloads/nZone...celess_360P.wmv

UlcerousVomitus

Chthon

Und eine EXTREME EDITION ist natürlich auch wieder in der Planung, ne?

Spasstiger

Crash

Das hängt wohl davon ab, wann und wie schlagkräftig ATI kontert.Originally posted by UlcerousVomitus@09.11.06, 00:58

Und eine EXTREME EDITION ist natürlich auch wieder in der Planung, ne?

Im zweiten Quartal 2007 steht ja evtl. schon der Refreshchip an (wird dann wohl der G81).

entweder bin ich blind oder blöd..sehe fast garkeinen unterscheid bei den hl shoots...lolOriginally posted by Spasstiger@08.11.06, 16:42

Mal was zum Thema Bildqualität, genauer gesagt zum Thema "anisotropes Filtern":

Der oberste Ausschnitt entspricht auch ungefähr der besten AF-Qualität, die mit GeForce-7-Karten möglich ist.

Hier noch was Nettes:

Die Bildqualitätskrone geht damit wieder an Nvidia zurück. Schön, dass Nvidia nicht nur mit ATI gleichgezogen hat, sondern sogar noch neue Maßstäbe setzt.

DoomDoctor20

Arch-Vile

Was hat denn die Frau für eine hässliche Nase?

Also ist echt unglaublich was für hohe Auflösungen mittlerweile zu realisieren sind

Also ist echt unglaublich was für hohe Auflösungen mittlerweile zu realisieren sind

ein feiner review...

http://hardtecs4u.com/reviews/2006/nvidia_g80/

und hier ein interessanter überblick inkl. vieler links...

http://www.3dcenter.de/artikel/2006/11-08.php

http://hardtecs4u.com/reviews/2006/nvidia_g80/

und hier ein interessanter überblick inkl. vieler links...

http://www.3dcenter.de/artikel/2006/11-08.php

DoomDoctor20

Arch-Vile

Ich kauf mir die Karte im April zu 99,99999%. Die Leistungssteigerung um 60-100% ist ja unglaublich.